A China está preparando regras específicas para IAs que simulam personalidade humana e constroem vínculo emocional. A proposta exige avisos claros de uso excessivo, monitoramento de sinais de dependência, intervenções em sofrimento psicológico e responsabilidade do fornecedor por todo o ciclo do produto.

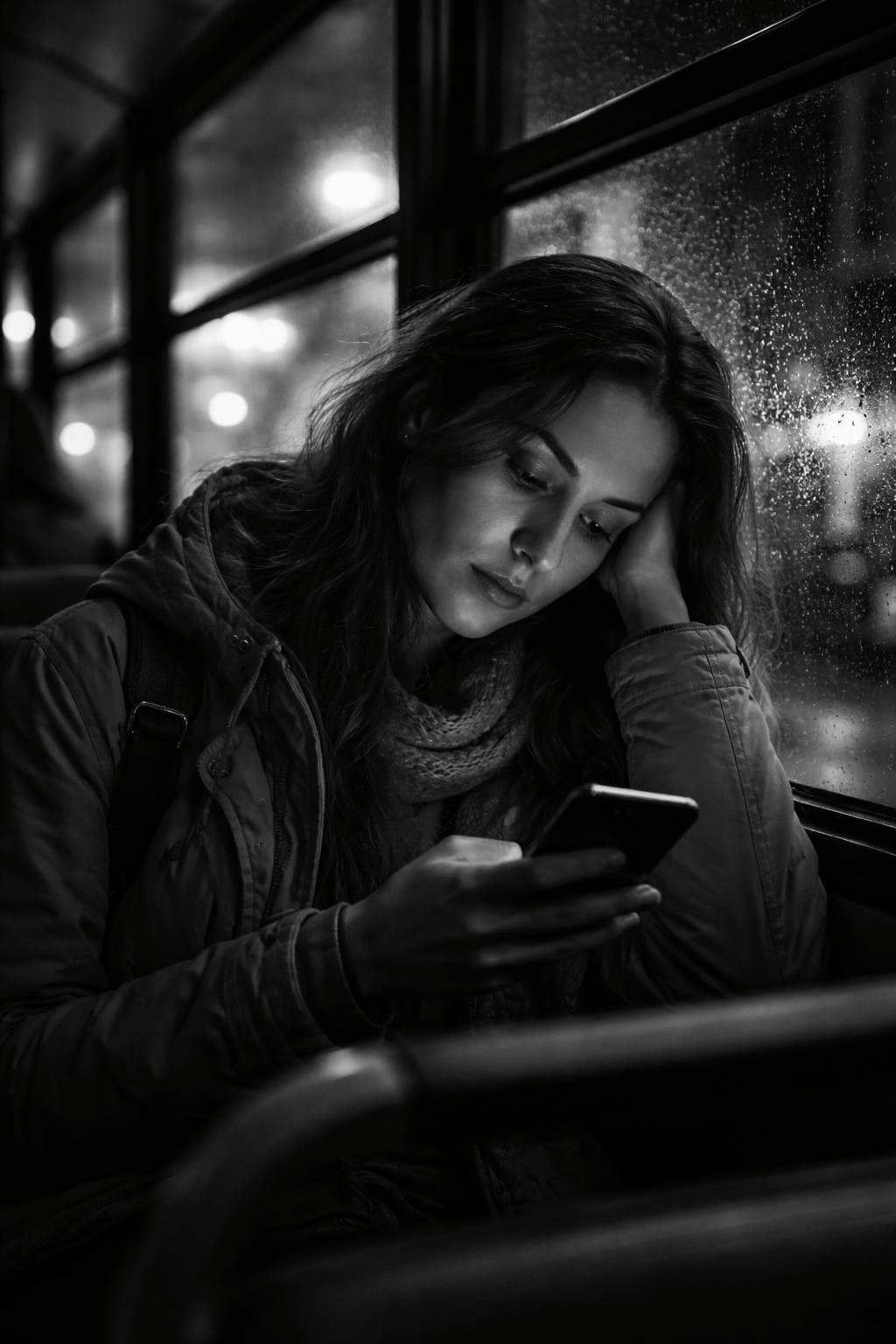

Esta regulação não é sobre código, modelo ou algoritmo. É sobre gente. Gente que passa tempo demais conversando com algo que parece humano, responde como humano e oferece presença sem os altos e baixos de qualquer relacionamento.

Chatbots hoje não são mais só ferramentas. Eles escutam, acolhem, respondem com paciência infinita. Em muitos casos, fazem isso melhor do que as pessoas ao redor.

Mas quando uma IA começa a suprir carências emocionais, o risco deixa de ser técnico e passa a ser psicológico e social. Por isso o foco da regulação não é eficiência, é dependência. Não é inovação, é vínculo.

E a verdade é que a tensão não está na tecnologia. Está no vazio que ela ocupa.O problema nunca é a ferramenta. É sempre anterior. É quem usa.

A raiz não é a IA emocional

Uma IA só cria laço emocional se alguém estiver disponível para criar esse laço. Ela só vira companhia quando já existe solidão. Ela só substitui relações quando as relações já estavam frágeis.

Regular a IA é lidar com o sintoma. O que está por trás é mais profundo.

Pessoas que não aprenderam a sustentar relações reais, com conflito, frustração e limite, tendem a preferir relações sem risco. A IA oferece isso. Presença sem cobrança. Escuta sem confronto. Afeto sem reciprocidade.

Isso não é tecnologia avançada. É uma fuga da realidade muito bem empacotada.

Por que a China puxou esse freio

Ao exigir alertas de uso excessivo, detecção de dependência e intervenção em sofrimento emocional, a China está dizendo algo claro: vínculo emocional artificial não é neutro.

Quando um produto começa a interferir na forma como alguém se relaciona consigo mesmo e com os outros, surge dever de cuidado. Isso vale para remédios, jogos, redes sociais e agora para IA.

O ponto cego do debate

Muita gente discute se a IA pode ou não criar laços emocionais, mas o fato é que essa pergunta já ficou para trás. O debate real precisa ser outro: o que acontece com quem transfere para a IA o que não consegue sustentar na vida real.

Nenhuma regulação resolve isso sozinha.

A ferramenta amplifica o que já existe. Se existe autoconsciência, a IA vira apoio. Se existe vazio, ela vira muleta. Se existe fuga, ela vira esconderijo.

O que realmente precisa ser aprendido

Relações sociais saudáveis não nascem de tecnologia melhor. Nascem de gente mais consciente.

Viver com leveza, assertividade, tolerância e uma visão menos hostil do mundo não é soft skill opcional. É infraestrutura emocional. E essa infraestrutura começa antes de qualquer relação externa. Começa na relação consigo mesmo.

É o autoconhecimento que define se você usa uma ferramenta ou se se perde dentro dela.

A IA só expõe o problema

A China não está exagerando. Está antecipando.

O direito está chegando depois do impacto, como sempre. Mas o alerta mais importante não é jurídico. É humano.

Enquanto a discussão for apenas sobre regular a ferramenta, o verdadeiro problema vai continuar escapando. Afinal, nenhuma IA cria dependência sozinha. Ela só encontra terreno fértil. E isso diz muito mais sobre nós do que sobre a IA.

Deixe um comentário